Inteligência Emocional de IA para Gestão de Riscos Éticos

- Marketing Team

- 20 de out.

- 12 min de leitura

Quando falamos em inteligência artificial (IA) ou inteligência emocional , não estamos descrevendo uma máquina que se sente feliz ou triste. Estamos falando de sistemas de IA que reconhecem eticamente padrões de comunicação correlacionados a comportamentos humanos e riscos potenciais. Nos complexos ambientes de trabalho atuais, as organizações enfrentam ameaças internas crescentes, como fraude, má conduta e não conformidade, que as ferramentas tradicionais muitas vezes ignoram. O Logical Commander resolve isso fornecendo uma plataforma compatível com a EPPA, priorizando a privacidade, que detecta indicadores de risco precoces em dados anonimizados. Nossa IA ética capacita as equipes de RH, Compliance e Segurança a migrar do controle reativo de danos para a prevenção proativa, fortalecendo a integridade e protegendo a dignidade humana, ao mesmo tempo em que proporciona um ROI mensurável.

Por que as ferramentas tradicionais de risco ignoram o comportamento humano

Sejamos honestos, as ferramentas tradicionais de conformidade e gestão de riscos são excelentes em uma coisa: rastrear dados em preto e branco. Elas podem monitorar registros de acesso, sinalizar violações de palavras-chave e garantir que listas de verificação de procedimentos sejam cumpridas. Mas operam com um enorme ponto cego — a dinâmica humana sutil e evolutiva que quase sempre antecede um incidente grave, como fraude, má conduta ou ameaça interna.

Esses sistemas legados são, por natureza, reativos. Eles soam o alarme somente após uma regra ser quebrada, o que deixa as organizações presas em um ciclo constante de controle de danos. Eles simplesmente não conseguem analisar as áreas cinzentas do comportamento humano, como uma mudança repentina no estilo de comunicação, o aumento do atrito dentro de uma equipe ou os sinais silenciosos de desengajamento que indicam que um problema está se formando logo abaixo da superfície.

Os limites dos métodos convencionais

É exatamente aqui que a inteligência artificial e a inteligência emocional mudam o jogo. Não se trata de monitorar indivíduos ou tentar interpretar seus sentimentos pessoais — isso seria uma clara violação das diretrizes da EPPA. Trata -se de detectar mudanças objetivas e baseadas em dados na comunicação que indiquem um desalinhamento com os padrões éticos ou um aumento nos indicadores de risco organizacional.

Pense nisso. Um aumento repentino de comunicação fragmentada, negativa ou fora do horário comercial em um departamento pode ser um sinal precoce de esgotamento ou de um projeto em dificuldades. Suas ferramentas tradicionais ignorariam isso completamente. E embora métodos convencionais, como programas de treinamento de conscientização em segurança que reduzem o risco humano , sejam projetados para corrigir vulnerabilidades humanas, muitas vezes falham em prever essas sutis mudanças comportamentais antes que elas aconteçam.

Uma alternativa proativa e ética

A plataforma compatível com a EPPA da Logical Commander analisa dados anonimizados para identificar esses padrões de forma ética e eficaz. Como um dos nossos principais diferenciais, nossa IA ética e não intrusiva foca em indicadores de risco sistêmico em vez de ações individuais, ajudando as organizações a finalmente migrar da resposta reativa a incidentes para a prevenção proativa de riscos. O resultado é um ambiente de trabalho mais seguro, colaborativo e resiliente.

Nossa tecnologia permite que as equipes de RH, Compliance e Segurança enxerguem os fatores subjacentes ao risco. Isso permite que elas se antecipem ao problema e abordem as causas-raiz — como pressão excessiva ou canais de comunicação quebrados — antes que se transformem em incidentes dispendiosos e prejudiciais. E podem fazer tudo isso preservando a privacidade e a dignidade dos funcionários.

Decodificando o risco humano com inteligência emocional de IA

Vamos esclarecer uma coisa. Quando falamos de inteligência artificial (IA) e inteligência emocional em um ambiente empresarial, não estamos construindo máquinas que "sentem". Pense mais como um gerente experiente que consegue entrar em uma sala e sentir imediatamente a tensão em uma equipe, apenas observando como eles interagem. É reconhecimento de padrões.

A tecnologia do Logical Commander é esse gestor, mas operando em escala empresarial. Ela analisa dados de comunicação anônimos para identificar padrões — a linguagem corporal digital — que sinalizam conflitos crescentes, desinteresse ou até mesmo um afastamento das normas éticas. Isso não é leitura de mentes. É uma análise objetiva e baseada em dados que sinaliza riscos elevados ao capital humano antes que eles transbordem.

Este não é mais um conceito de nicho. O mercado global de IA para Emoções foi avaliado em aproximadamente US$ 2,9 bilhões e deve crescer a uma taxa anual composta de cerca de 21,7% entre 2025 e 2034. Esse crescimento é impulsionado pela necessidade urgente de todos os setores de compreender os sinais comportamentais humanos ocultos nos dados. Para saber mais sobre essa tendência, confira os dados sobre o crescimento e os impulsionadores do mercado de IA para Emoções .

A Estrutura Ética para Insights Orientados por IA

Nossa abordagem está a mundos de distância da vigilância invasiva de funcionários. Nunca acessamos conteúdo pessoal nem monitoramos indivíduos. Ponto final. Todo o sistema foi projetado para oferecer à liderança uma visão anônima e de alto nível da saúde organizacional, sinalizando problemas sistêmicos muito antes que se tornem crises pessoais. Este design que prioriza a privacidade é um diferencial fundamental, respaldado pela conformidade com ISO 27K, GDPR e CPRA.

Ao focar na análise comportamental em nível de grupo, as organizações podem identificar áreas de atrito ou declínio da consistência ética sem comprometer a privacidade individual. Trata-se de gerenciar riscos sistêmicos, não de policiar funcionários.

Plataformas como a nossa solução [E-Commander](https://www.logicalcommander.com/e-commander) são construídas com base neste princípio. Seguimos os mais rigorosos padrões de privacidade — incluindo ISO 27001/27701, GDPR e CPRA — para garantir que cada insight seja gerado de forma ética e segura. Esse compromisso é crucial para construir confiança e criar uma cultura em que a tecnologia seja vista como uma ferramenta de apoio, e não como uma ferramenta disciplinar.

Insights práticos para gestão proativa de riscos

Ao compreender esses indicadores de risco, você poderá finalmente mudar de uma postura reativa para uma proativa. Para uma análise mais aprofundada dessa mudança, confira nosso guia para gestão de riscos humanos com IA .

Aqui estão algumas maneiras de transformar esses insights em ações:

Insight Acionável 1: Procure Padrões Sistêmicos. Não se deixe levar por incidentes pontuais. Use dados agregados para identificar problemas recorrentes em departamentos ou equipes específicas. É aí que você encontrará as causas-raiz, como falta de recursos ou lacunas na liderança.

Insight Acionável 2: Correlacione Dados de Comunicação com Resultados. Comece a conectar os pontos. Como as mudanças no sentimento ou na frequência da comunicação se alinham com atrasos em projetos ou rotatividade de funcionários? Isso lhe dá uma prova mensurável de como a dinâmica humana está afetando os resultados financeiros.

Insight Acionável 3: Promova a colaboração entre departamentos. Faça com que RH, Compliance e Segurança conversem entre si. Compartilhar insights de alto nível permite que você crie uma estratégia unificada para lidar com riscos antes que eles causem danos reais.

Como a IA enxerga o risco antes que ele se torne uma crise

O verdadeiro valor da inteligência artificial (IA) não é um conceito teórico e distante. Trata-se de captar os sinais que todos os outros não percebem e agir antes que um pequeno problema se transforme em uma crise generalizada. Ela transforma fundamentalmente a gestão de riscos de uma função reativa e de controle de danos para uma estratégia proativa e preventiva.

Imagine uma equipe de projeto de alto risco correndo contra um prazo impossível. Seu software padrão de gerenciamento de projetos provavelmente dará sinal verde, desde que os marcos sejam alcançados. Essas ferramentas enxergam os resultados , mas são completamente cegas à dinâmica humana — o estresse, o esgotamento, o atrito — que impulsiona esses resultados.

É aqui que uma IA ética oferece uma vantagem crucial. Ela não precisa ler um único e-mail ou mensagem. Em vez disso, analisa metadados de comunicação anônimos para identificar tendências preocupantes que se acumulam na equipe.

Um cenário prático em ação

Cenário: Uma empresa de serviços financeiros está se preparando para o lançamento de um grande produto. A equipe do projeto está sob imensa pressão.

O que a IA detecta: a IA do Logical Commander detecta um aumento de 45% na comunicação fora do horário comercial, um aumento de 60% nas mensagens fragmentadas (curtas e rápidas) e uma mudança negativa no tom de comunicação dentro dos canais dedicados do projeto ao longo de três semanas.

Indicador de Risco: Não se trata de falhas individuais, mas sim de indicadores claros de esgotamento sistêmico e pressão insustentável. Isso aumenta o risco de erros dispendiosos, manuseio incorreto de dados ou demissão de membros importantes da equipe antes do lançamento.

Intervenção proativa: em vez de esperar por um desastre, o RH e a liderança do projeto recebem um alerta anônimo sobre os indicadores de alto estresse da equipe. Eles intervêm reavaliando o cronograma, realocando recursos e fornecendo suporte direcionado, evitando o descarrilamento do projeto e protegendo o bem-estar dos funcionários.

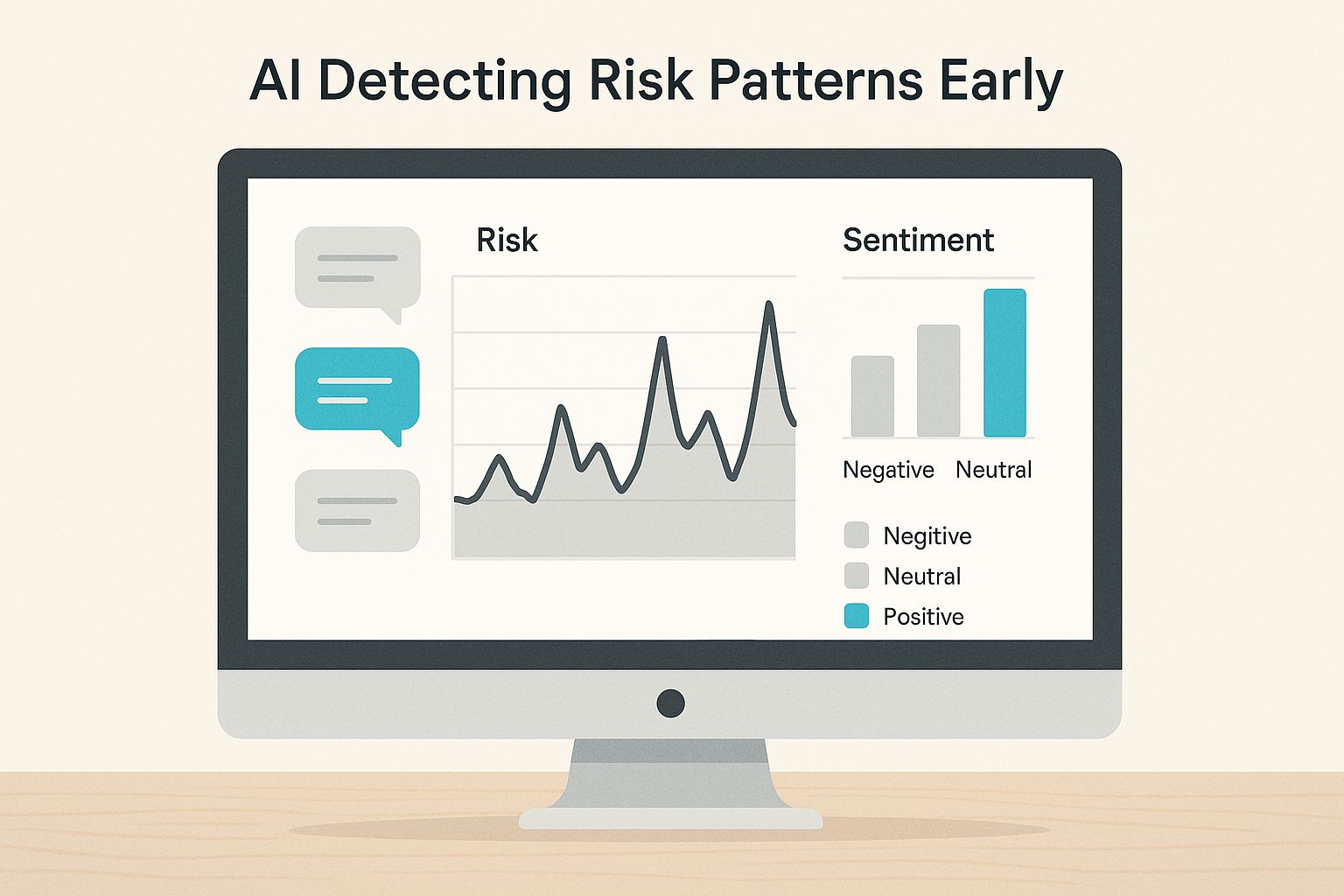

Este visual mostra exatamente como a IA pode rastrear esses padrões ao longo do tempo, sinalizando os picos que sinalizam um risco crescente muito antes de um incidente acontecer.

A principal lição aqui é que o risco não é um evento único. É um processo. Identificar esses padrões comportamentais precocemente dá à liderança uma janela crucial para intervir antes que a barragem se rompa.

Da detecção à intervenção proativa

Munidos desse alerta precoce, os líderes de RH e compliance podem intervir. O objetivo não é apontar o dedo para os funcionários em dificuldades, mas sim corrigir o problema sistêmico que está causando a pressão. A conversa muda de "Quem está falhando?" para "O que está quebrado em nosso processo?".

Esse método não intrusivo permite que as organizações resolvam problemas de causa raiz — como prazos irrealistas ou escassez de recursos — antes que eles resultem em falha do projeto, fraude ou violação significativa de conformidade.

Essa postura proativa proporciona um ROI claro e mensurável. Ao prevenir apenas um incidente grave, o sistema se paga muitas vezes. Soluções como nossas plataformas E-Commander e Risk-HR são projetadas especificamente para fornecer esses alertas antecipados, de forma ética e eficaz. Para se aprofundar nessa abordagem, confira nosso guia sobre [detecção de ameaças internas com IA ética](https://www.logicalcommander.com/post/detecting-insider-threats-with-ethical-ai) .

Navegando pela IA Ética e Conformidade com EPPA

Ética e privacidade não são apenas recursos que adicionamos; são a base da nossa plataforma. Para que a inteligência emocional artificial seja uma ferramenta genuína para mudanças positivas, ela precisa operar dentro de uma estrutura ética rigorosa. É exatamente por isso que o Logical Commander foi desenvolvido do zero para cumprir regulamentações como a Lei de Proteção do Polígrafo de Funcionários (EPPA), juntamente com padrões globais de privacidade.

Nosso compromisso é tão profundo que molda até as palavras que usamos. Você nunca nos ouvirá usar termos enganosos ou restritos pela EPPA, como "detecção de confiança" ou "verificação da verdade". Em vez disso, nos concentramos em indicadores mensuráveis e objetivos de "consistência ética" e "alinhamento de integridade". Não se trata apenas de semântica; é um reflexo direto da nossa crença fundamental de que a tecnologia deve apoiar as pessoas, não vigiá-las.

Um design que prioriza a privacidade

Toda a nossa plataforma é projetada para privacidade. Possuímos as certificações ISO 27001/27701 e cumprimos os rigorosos requisitos do GDPR e do CPRA , garantindo que cada dado seja tratado com o mais alto nível de segurança e respeito aos direitos individuais. Nossa tecnologia fornece às equipes de RH, Compliance e Jurídico os insights essenciais necessários sem recorrer a monitoramento invasivo.

Uma parte fundamental da implantação de IA em áreas sensíveis é ter um plano sólido para garantir a conformidade legal com a IA . Isso não é algo que se descobre depois — precisa ser incorporado desde o início para gerar confiança.

Acreditamos que uma organização saudável se baseia na confiança, e a tecnologia deve reforçar essa confiança, não miná-la. Nossa abordagem não intrusiva posiciona nossa plataforma como uma ferramenta de apoio à manutenção de um ambiente de trabalho saudável, e não disciplinar.

A demanda por esse tipo de tecnologia está crescendo exponencialmente. O mercado de tecnologia de inteligência emocional (IE) deve disparar de cerca de US$ 2,6 bilhões para US$ 23 bilhões até 2035. Esse crescimento massivo é impulsionado por uma necessidade real de ferramentas que ajudem a promover culturas emocionalmente inteligentes, especialmente com a crescente popularização do trabalho remoto.

Construindo confiança por meio de tecnologia ética

Então, como funciona na prática? Em vez de isolar indivíduos, nossa abordagem se concentra em padrões agregados e anônimos que ajudam os líderes a identificar riscos sistêmicos. Isso permite que as organizações se antecipem às causas raiz — como pressão excessiva sobre uma equipe ou falhas na comunicação — antes que se transformem em incidentes graves.

Você pode se aprofundar mais nisso em nosso artigo sobre como navegar pela ética da IA e conformidade com a EPPA em RH .

Está pensando em criar sua própria estratégia ética de IA? Aqui estão algumas dicas práticas para você começar:

Priorize a Análise Sistêmica: concentre-se em dados anônimos e de alto nível para entender a saúde da equipe e do departamento. Isso mantém o foco na resolução de problemas organizacionais, e não em funcionários individuais.

Seja transparente sobre o uso da IA: comunique claramente como e por que a IA está sendo usada. Enfatize que seu objetivo é melhorar a saúde no local de trabalho e prevenir riscos, não monitorar o comportamento pessoal.

Escolha Parceiros em Conformidade com a EPPA: Selecione seus parceiros de tecnologia com cuidado. Certifique-se de que eles compartilham seu compromisso com princípios éticos e de privacidade em primeiro lugar e possam comprovar que cumprem as principais regulamentações.

Nossa abordagem que prioriza a privacidade e está em conformidade com a EPPA contrasta fortemente com métodos mais antigos e invasivos de monitoramento de funcionários. A diferença está em construir confiança em vez de criar medo.

Estrutura ética da IA versus vigilância tradicional

Recurso | Comandante Lógico (IA Ética) | Ferramentas de vigilância tradicionais |

|---|---|---|

Foco | Risco sistêmico e saúde organizacional | Comportamento individual e quebra de regras |

Tipo de dados | Padrões agregados e anônimos | Atividade de usuário pessoalmente identificável |

Meta | Prevenção proativa de riscos e construção de cultura | Disciplina reativa e coleta de evidências |

Experiência do Funcionário | Solidário, digno e transparente | Intrusivo, estressante e secreto |

Conformidade | Conformidade integrada com EPPA e GDPR | Alto risco de violação das leis de privacidade e EPPA |

Em última análise, escolher uma estrutura de IA ética não é apenas uma decisão de conformidade — é uma questão cultural. Ela sinaliza aos seus funcionários que você confia neles e está empenhado em criar um ambiente de trabalho mais saudável e seguro para todos.

Etapas práticas para fortalecer sua estratégia de risco

Compreender o poder da inteligência emocional impulsionada pela IA é uma coisa. Pô-la em prática é outra completamente diferente. Passar de uma boa ideia para uma estratégia concreta significa mudar fundamentalmente a forma como sua organização enxerga e lida com o risco humano. Trata-se de construir uma infraestrutura mais conectada, responsiva e ética desde o início.

Com algumas medidas concretas, você pode construir uma estrutura que não apenas sinaliza riscos após o ocorrido, mas também identifica as causas-raiz, fortalecendo todo o seu programa de integridade e conformidade. Essas não são apenas teorias; são estratégias projetadas para gerar valor imediato e preparar você para a saúde organizacional a longo prazo.

Quebrar os silos de informação

Os maiores riscos quase sempre surgem nas divergências entre os departamentos. O RH percebe os sinais de esgotamento, a Segurança percebe padrões estranhos de acesso a dados e o Jurídico está lidando com algumas reclamações isoladas. Quando essas informações nunca saem do seu devido lugar, ninguém conecta os pontos até que seja tarde demais.

É aqui que um painel de riscos unificado se torna inegociável para a colaboração entre departamentos . Ao criar uma única fonte de verdade, plataformas como o [E-Commander](https://www.logicalcommander.com/e-commander) oferecem aos departamentos de RH, Jurídico e Segurança uma visão compartilhada e em tempo real do que está acontecendo em toda a organização. Isso finalmente permite que suas equipes tenham uma visão completa e coordenem uma resposta proativa.

Mudar o foco da culpa individual para questões sistêmicas é um pilar fundamental da gestão de riscos éticos. Ao observar um padrão de estresse em uma equipe, o objetivo é corrigir o processo subjacente, não punir as pessoas que trabalham nele.

Aproveite um ecossistema de parceiros globais

Tentar implementar a gestão de riscos com IA em todo o mundo traz consigo uma série de dificuldades, desde lidar com regulamentações locais peculiares até entender diferenças culturais profundas. Uma abordagem única para todos está condenada desde o início.

É por isso que um ecossistema de parceiros forte é tão crucial. O mercado global de IA para emoções está em plena expansão — só a América do Norte detém cerca de 39,2% da participação de mercado, e a projeção é de que o mercado total atinja US$ 13,4 bilhões até 2033. Esse crescimento não se deve apenas à tecnologia; trata-se da crescente demanda por expertise localizada. Descubra mais insights sobre o mercado de IA para emoções .

Trabalhar com um provedor com rede global significa ter pessoas no local que entendem da situação. Nosso programa PartnerLC conecta você a especialistas locais que entendem de conformidade regional e podem ajudar a personalizar a implementação para que ela se encaixe perfeitamente, garantindo uma implementação tranquila e eficaz em qualquer lugar do mundo. Este ecossistema de parceiros para cobertura global é um diferencial fundamental que garante o sucesso de nossos clientes.

Se você está pronto para criar uma estratégia de risco mais resiliente e proativa, comece aqui:

Insight Acionável 1: Implemente um Painel Unificado. Centralize os indicadores de risco para que RH, Compliance e Segurança possam finalmente trabalhar em conjunto.

Insight Acionável 2: Concentre-se em Soluções Sistêmicas. Use insights baseados em IA para encontrar e corrigir as causas-raiz do risco, como pressão irreal ou canais de comunicação quebrados.

Insight Acionável 3: Junte-se a uma Rede de Parceiros. Expanda suas capacidades e garanta a conformidade global juntando-se à nossa rede PartnerLC , projetada para integradores e consultores como você.

O futuro é proativo e ético

O futuro da gestão de riscos internos já chegou e está centrado na inteligência emocional e na inteligência artificial — não como uma ferramenta de vigilância, mas como um sistema para compreender a saúde organizacional. Ir além do controle reativo de danos significa adotar uma abordagem proativa e ética que identifique padrões comportamentais de risco muito antes que se transformem em incidentes dispendiosos. É exatamente para isso que o Logical Commander foi criado.

Oferecemos detecção em tempo real e um ROI mensurável, tudo isso construído com base em uma política de privacidade em conformidade com a EPPA. Nossa plataforma ajuda líderes a fortalecer a integridade e a construir uma cultura resiliente, abordando questões sistêmicas, em vez de monitorar indivíduos.

Pronto para mudar sua estratégia de risco da visão retrospectiva para a visão prospectiva?

Solicite uma demonstração para ver como nossa plataforma de IA ética transforma o gerenciamento de riscos internos ou junte-se à nossa rede PartnerLC para levar essas soluções inovadoras aos seus clientes.

Conheça primeiro. Aja rápido. IA ética para integridade, conformidade e dignidade humana.

%20(2)_edited.png)