Inteligencia emocional basada en IA para la gestión ética del riesgo

- Marketing Team

- 20 oct

- 12 Min. de lectura

Cuando hablamos de inteligencia artificial e inteligencia emocional , no nos referimos a una máquina que se siente feliz o triste. Hablamos de sistemas de IA que reconocen éticamente patrones de comunicación correlacionados con comportamientos humanos y riesgos potenciales. En los complejos entornos laborales actuales, las organizaciones se enfrentan a crecientes amenazas internas como el fraude, la mala conducta y el incumplimiento, que las herramientas tradicionales suelen pasar por alto. Logical Commander soluciona esto proporcionando una plataforma que prioriza la privacidad y cumple con la EPPA, detectando indicadores de riesgo tempranos en datos anónimos. Nuestra IA ética permite a los equipos de RR. HH., Cumplimiento y Seguridad pasar del control de daños reactivo a la prevención proactiva, fortaleciendo la integridad y protegiendo la dignidad humana, a la vez que ofrece un retorno de la inversión (ROI) medible.

Por qué las herramientas de riesgo tradicionales no detectan el comportamiento humano

Seamos sinceros, las herramientas tradicionales de cumplimiento y gestión de riesgos son excelentes en una cosa: el seguimiento de datos confidenciales. Permiten supervisar registros de acceso, detectar infracciones de palabras clave y garantizar que se cumplan las listas de verificación de procedimientos. Sin embargo, operan con un punto ciego enorme: la dinámica humana sutil y cambiante que casi siempre precede a un incidente grave como fraude, mala conducta o una amenaza interna.

Estos sistemas heredados son, por naturaleza, reactivos. Solo dan la alarma cuando se infringe una regla, lo que deja a las organizaciones atrapadas en un ciclo constante de control de daños. Simplemente no pueden analizar las zonas grises del comportamiento humano, como un cambio repentino en el estilo de comunicación, la creciente fricción dentro de un equipo o las señales silenciosas de desconexión que indican que un problema se está gestando bajo la superficie.

Los límites de los métodos convencionales

Aquí es precisamente donde la inteligencia artificial y la inteligencia emocional cambian las reglas del juego. No se trata de monitorear a las personas ni de intentar interpretar sus sentimientos personales, ya que eso constituiría una clara violación de las directrices de la EPPA. Se trata de detectar cambios objetivos y basados en datos en la comunicación que indiquen un incumplimiento de los estándares éticos o un aumento en los indicadores de riesgo organizacional.

Piénselo. Un aumento repentino de la comunicación fragmentada, negativa o fuera del horario laboral en un departamento podría ser una señal temprana de agotamiento o de un proyecto en crisis. Sus herramientas tradicionales lo pasarían por alto por completo. Y si bien los métodos convencionales, como los programas de capacitación en seguridad que reducen el riesgo humano , están diseñados para corregir las vulnerabilidades humanas, a menudo no logran predecir estos sutiles cambios de comportamiento antes de que ocurran.

Una alternativa proactiva y ética

La plataforma de Logical Commander, compatible con la EPPA, analiza datos anónimos para detectar estos patrones de forma ética y eficaz. Como uno de nuestros principales diferenciadores, nuestra IA ética y no intrusiva se centra en indicadores de riesgo sistémico en lugar de acciones individuales, lo que ayuda a las organizaciones a pasar de la respuesta reactiva a incidentes a la prevención proactiva de riesgos. El resultado es un entorno de trabajo más seguro, colaborativo y resiliente.

Nuestra tecnología permite a los equipos de RR. HH., Cumplimiento y Seguridad identificar las causas subyacentes del riesgo. Esto les permite anticiparse al problema y abordar las causas raíz, como la presión excesiva o la interrupción de los canales de comunicación, antes de que se conviertan en incidentes costosos y perjudiciales. Y todo ello respetando la privacidad y la dignidad de los empleados.

Decodificando el riesgo humano con inteligencia emocional de IA

Aclaremos algo. Cuando hablamos de inteligencia artificial e inteligencia emocional en el ámbito empresarial, no estamos construyendo máquinas que "sienten". Piénselo más bien como un gerente experimentado que puede entrar en una sala e inmediatamente percibir la tensión en un equipo, con solo observar cómo interactúan. Es reconocimiento de patrones.

La tecnología de Logical Commander es ese gestor, pero operando a escala empresarial. Analiza datos de comunicación anónimos para detectar patrones —el lenguaje corporal digital— que indican un creciente conflicto, desapego o incluso un desvío de las normas éticas. No se trata de leer la mente. Es un análisis objetivo y basado en datos que detecta un mayor riesgo para el capital humano antes de que se desborde.

Este ya no es un concepto de nicho. El mercado global de IA para las emociones se valoró en aproximadamente 2900 millones de dólares y se espera que crezca a una tasa anual compuesta de aproximadamente el 21,7 % entre 2025 y 2034. Este crecimiento se debe a la apremiante necesidad en todos los sectores de comprender las señales del comportamiento humano ocultas en los datos. Para más información sobre esta tendencia, consulte los datos sobre el crecimiento y los impulsores del mercado de IA para las emociones .

El marco ético para la información basada en IA

Nuestro enfoque es completamente diferente a la vigilancia invasiva de empleados. Nunca accedemos a contenido personal ni monitoreamos a personas. Punto final. Todo el sistema está diseñado para brindar a la gerencia una visión anónima y de alto nivel del estado de la organización, detectando problemas sistémicos mucho antes de que se conviertan en crisis personales. Este diseño que prioriza la privacidad es un diferenciador fundamental, respaldado por el cumplimiento de las normas ISO 27K, RGPD y CPRA.

Al centrarse en el análisis del comportamiento a nivel de grupo, las organizaciones pueden identificar áreas de fricción o una disminución de la coherencia ética sin comprometer la privacidad individual. Se trata de gestionar el riesgo sistémico, no de vigilar a los empleados.

Plataformas como nuestra solución [E-Commander](https://www.logicalcommander.com/e-commander) se basan en este principio. Cumplimos con los estándares más estrictos que priorizan la privacidad, como ISO 27001/27701, RGPD y CPRA, para garantizar que toda la información se genere de forma ética y segura. Este compromiso es crucial para generar confianza y crear una cultura donde la tecnología se considere una herramienta de apoyo, no una disciplina.

Información práctica para una gestión proactiva de riesgos

Cuando comprenda estos indicadores de riesgo, podrá finalmente pasar de una postura reactiva a una proactiva. Para profundizar en este cambio, consulte nuestra guía sobre la gestión de riesgos humanos impulsada por IA .

A continuación se presentan algunas formas de convertir estos conocimientos en acción:

Perspectiva práctica 1: Busque patrones sistémicos. No se deje llevar por incidentes puntuales. Utilice datos agregados para identificar problemas recurrentes en departamentos o equipos específicos. Ahí es donde encontrará las causas raíz, como la falta de recursos o una falta de liderazgo.

Perspectiva práctica 2: Correlacionar los datos de comunicación con los resultados. Empiece a conectar los puntos. ¿Cómo se relacionan los cambios en la percepción o la frecuencia de la comunicación con los retrasos en los proyectos o la rotación de personal? Esto le proporciona una prueba medible de cómo la dinámica humana está impactando en los resultados.

Perspectiva práctica 3: Fomentar la colaboración interdepartamental. Lograr la colaboración entre RR. HH., Cumplimiento y Seguridad. Compartir información de alto nivel permite desarrollar una estrategia unificada para abordar los riesgos antes de que causen daños reales.

Cómo la IA detecta el riesgo antes de que se convierta en una crisis

El verdadero valor de la inteligencia emocional (IA) no reside en un concepto teórico y remoto. Se trata de captar las señales que todos pasan por alto y actuar antes de que un pequeño problema se convierta en una crisis grave. Transforma fundamentalmente la gestión de riesgos, pasando de una función reactiva de control de daños a una estrategia proactiva y preventiva.

Imagine un equipo de proyecto de alto riesgo que compite contra una fecha límite imposible. Su software de gestión de proyectos estándar probablemente le dará luz verde siempre que se alcancen los hitos. Estas herramientas ven el resultado , pero ignoran por completo la dinámica humana —el estrés, el agotamiento, la fricción— que lo impulsa.

Aquí es donde una IA ética te ofrece una ventaja crucial. No necesita leer ni un solo correo electrónico ni mensaje. En cambio, analiza metadatos de comunicación anónimos para detectar tendencias preocupantes que se están acumulando en el equipo.

Un escenario práctico en acción

Escenario: Una empresa de servicios financieros se prepara para el lanzamiento de un producto importante. El equipo del proyecto se encuentra bajo una enorme presión.

Qué detecta la IA: la IA de Logical Commander detecta un aumento del 45 % en la comunicación fuera del horario laboral, un aumento del 60 % en los mensajes fragmentados (breves y rápidos) y un cambio negativo en el tono de comunicación dentro de los canales dedicados del proyecto durante tres semanas.

El indicador de riesgo: No se trata de fallos individuales, sino de claros indicadores de agotamiento sistémico y presión insostenible. Esto aumenta el riesgo de errores costosos, mal manejo de datos o la renuncia de miembros clave del equipo antes del lanzamiento.

Intervención proactiva: En lugar de esperar a que ocurra un desastre, RR. HH. y la dirección del proyecto reciben una alerta anónima sobre los indicadores de alto estrés del equipo. Intervienen reevaluando el cronograma, reasignando recursos y brindando apoyo específico, evitando el descarrilamiento del proyecto y protegiendo el bienestar de los empleados.

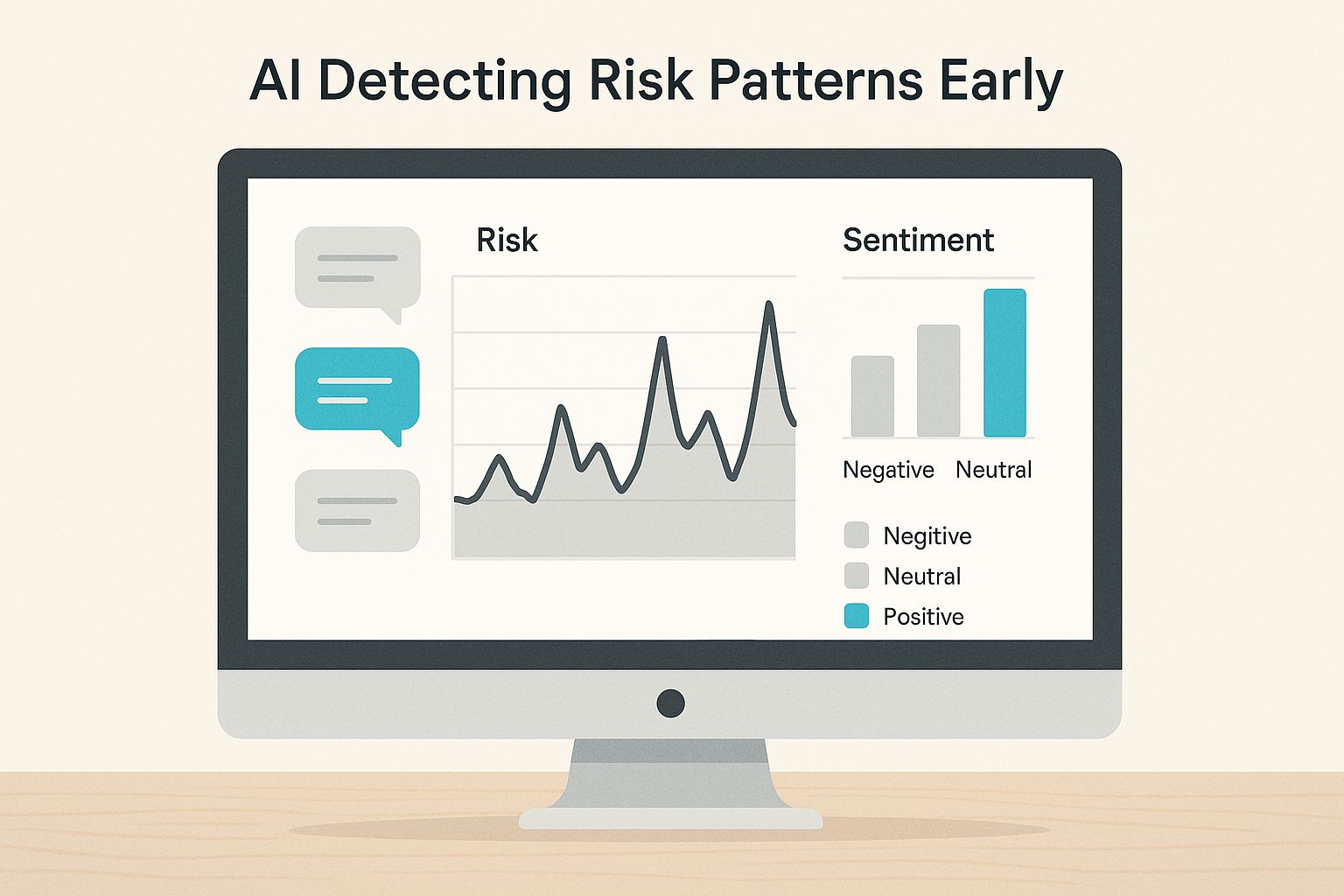

Este elemento visual muestra exactamente cómo la IA puede rastrear estos patrones a lo largo del tiempo, señalando los picos que indican un riesgo creciente mucho antes de que ocurra un incidente.

La conclusión clave es que el riesgo no es un evento único. Es un proceso. Detectar estos patrones de comportamiento a tiempo brinda al liderazgo una oportunidad crucial para intervenir antes de que se rompa la barrera.

De la detección a la intervención proactiva

Con esta alerta temprana, los responsables de RR. HH. y cumplimiento normativo pueden intervenir. El objetivo no es señalar a los empleados con dificultades, sino solucionar el problema sistémico que causa la presión. La conversación pasa de "¿Quién está fallando?" a "¿Qué falla en nuestro proceso?".

Este método no intrusivo permite a las organizaciones resolver problemas de raíz (como plazos poco realistas o escasez de recursos) antes de que resulten en un fracaso del proyecto, fraude o una violación importante del cumplimiento.

Esta postura proactiva ofrece un retorno de la inversión (ROI) claro y medible. Al prevenir un solo incidente grave, el sistema se amortiza con creces. Soluciones como nuestras plataformas E-Commander y Risk-HR están diseñadas específicamente para proporcionar estas alertas tempranas, tanto de forma ética como eficaz. Para profundizar en este enfoque, consulte nuestra guía sobre [detección de amenazas internas con IA ética](https://www.logicalcommander.com/post/detecting-insider-threats-with-ethical-ai) .

Navegando por la IA ética y el cumplimiento de la EPPA

La ética y la privacidad no son solo características que añadimos; son la base de nuestra plataforma. Para que la inteligencia artificial (IA) sea una herramienta genuina para el cambio positivo, debe operar dentro de un estricto marco ético. Precisamente por eso, Logical Commander se diseñó desde cero para cumplir con regulaciones como la Ley de Protección de Empleados mediante Polígrafo (EPPA), así como con los estándares globales de privacidad.

Nuestro compromiso es tan profundo que incluso influye en el vocabulario que usamos. Nunca nos oirá usar términos engañosos o restringidos por la EPPA, como "detección de confianza" o "verificación de la verdad". En cambio, nos centramos en indicadores medibles y objetivos de "coherencia ética" y "alineación con la integridad". No se trata solo de semántica; es un reflejo directo de nuestra convicción fundamental: la tecnología debe apoyar a las personas, no vigilarlas.

Un diseño que prioriza la privacidad

Toda nuestra plataforma está diseñada para garantizar la privacidad. Contamos con las certificaciones ISO 27001/27701 y cumplimos con los exigentes requisitos del RGPD y la CPRA , lo que garantiza que cada dato se gestione con el máximo nivel de seguridad y respeto por los derechos individuales. Nuestra tecnología proporciona a los equipos de RR. HH., Cumplimiento Normativo y Legal la información crucial que necesitan sin recurrir a una monitorización invasiva.

Una parte fundamental de la implementación de IA en áreas sensibles es contar con un plan sólido para garantizar el cumplimiento legal de la IA . Esto no es algo que se defina más adelante; debe integrarse desde el principio para generar confianza.

Creemos que una organización saludable se basa en la confianza, y la tecnología debe reforzarla, no debilitarla. Nuestro enfoque no intrusivo posiciona nuestra plataforma como una herramienta de apoyo para mantener un entorno de trabajo saludable, no como una herramienta disciplinaria.

La demanda de este tipo de tecnología está en auge. Se proyecta que el mercado tecnológico de inteligencia emocional (IE) se disparará de aproximadamente 2.600 millones de dólares a 23.000 millones de dólares para 2035. Este crecimiento masivo se debe a la necesidad real de herramientas que fomenten culturas de inteligencia emocional, especialmente a medida que el teletrabajo se vuelve más común.

Generando confianza mediante tecnología ética

¿Cómo funciona esto en la práctica? En lugar de identificar a individuos, nuestro enfoque se centra en patrones agregados y anónimos que ayudan a los líderes a detectar riesgos sistémicos. Esto permite a las organizaciones anticiparse a las causas fundamentales —como la presión excesiva en un equipo o una falla en la comunicación— antes de que se conviertan en incidentes graves.

Puede profundizar más en esto en nuestro artículo sobre cómo navegar por la ética de la IA y el cumplimiento de la EPPA en RR.HH.

¿Estás pensando en tu propia estrategia ética de IA? Aquí tienes algunas ideas prácticas para empezar:

Priorizar el análisis sistémico: Centrarse en datos anónimos de alto nivel para comprender la salud del equipo y del departamento. Esto centra la atención en la solución de problemas organizacionales, no en empleados individuales.

Sea transparente sobre el uso de la IA: Comunique claramente cómo y por qué se utiliza. Enfatice que su propósito es mejorar la salud en el trabajo y prevenir riesgos, no monitorear el comportamiento personal.

Elija socios que cumplan con la EPPA: Investigue cuidadosamente a sus socios tecnológicos. Asegúrese de que compartan su compromiso con los principios éticos que priorizan la privacidad y que puedan demostrar que cumplen con las regulaciones clave.

Nuestro enfoque, que prioriza la privacidad y cumple con la EPPA, contrasta marcadamente con los métodos más antiguos e intrusivos de monitoreo de empleados. La diferencia radica en generar confianza en lugar de generar miedo.

Marco ético de IA vs. vigilancia tradicional

Característica | Comandante lógico (IA ética) | Herramientas de vigilancia tradicionales |

|---|---|---|

Enfocar | Riesgo sistémico y salud organizacional | Comportamiento individual y violación de normas |

Tipo de datos | Patrones agregados y anónimos | Actividad de usuario personalmente identificable |

Meta | Prevención proactiva de riesgos y creación de cultura | Disciplina reactiva y recopilación de pruebas |

Experiencia del empleado | Solidario, digno y transparente | Intrusivo, estresante y reservado. |

Cumplimiento | Cumplimiento integrado de EPPA y GDPR | Alto riesgo de violar la EPPA y las leyes de privacidad |

En definitiva, elegir un marco de IA ético no es solo una decisión de cumplimiento normativo, sino también cultural. Les demuestra a sus empleados que confía en ellos y que está comprometido con la creación de un entorno de trabajo más saludable y seguro para todos.

Pasos prácticos para fortalecer su estrategia de riesgo

Comprender el poder de la inteligencia emocional impulsada por la IA es una cosa. Ponerla en práctica es algo completamente distinto. Pasar de una buena idea a una estrategia real implica cambiar radicalmente la forma en que su organización percibe y gestiona el riesgo humano. Se trata de construir una infraestructura más conectada, receptiva y ética desde cero.

Al adoptar medidas concretas, puede crear un marco que no solo detecte los riesgos a posteriori, sino que aborde las causas fundamentales, fortaleciendo así todo su programa de integridad y cumplimiento. No se trata solo de teorías; son estrategias diseñadas para generar valor inmediato y prepararlo para una salud organizacional a largo plazo.

Romper los silos de información

Los mayores riesgos casi siempre surgen en las brechas entre departamentos. Recursos Humanos detecta señales de agotamiento, Seguridad detecta patrones extraños de acceso a datos y Legal gestiona algunas quejas aisladas. Cuando esa información nunca sale de su silo, nadie ata los cabos hasta que es demasiado tarde.

Aquí es donde un panel de control de riesgos unificado se vuelve indispensable para la colaboración interdepartamental . Al crear una única fuente de información, plataformas como [E-Commander](https://www.logicalcommander.com/e-commander) ofrecen a RR. HH., Legal y Seguridad una visión compartida y en tiempo real de lo que sucede en toda la organización. Esto permite a sus equipos tener una visión completa y coordinar una respuesta proactiva.

Cambiar el enfoque de la culpa individual a los problemas sistémicos es fundamental para la gestión ética de riesgos. Cuando se detecta un patrón de estrés en un equipo, el objetivo es corregir el proceso subyacente, no castigar a quienes trabajan en él.

Aproveche un ecosistema de socios global

Intentar implementar la gestión de riesgos basada en IA a nivel mundial conlleva sus propios problemas, desde lidiar con regulaciones locales peculiares hasta comprender profundas diferencias culturales. Un enfoque único está condenado al fracaso desde el principio.

Por eso es fundamental contar con un sólido ecosistema de socios. El mercado global de la IA emocional está en pleno auge: solo Norteamérica representa alrededor del 39,2 % de la cuota de mercado, y se proyecta que el mercado total alcance los 13 400 millones de dólares para 2033. Este crecimiento no se debe solo a la tecnología, sino también a la creciente demanda de experiencia local. Descubra más información sobre el mercado de la IA emocional .

Trabajar con un proveedor con una red global significa contar con personal local que lo comprende. Nuestro programa PartnerLC le conecta con expertos locales que comprenden el cumplimiento normativo regional y pueden ayudarle a adaptar la implementación a la perfección, garantizando una implementación fluida y eficaz en cualquier parte del mundo. Este ecosistema de socios con cobertura global es un factor diferenciador clave que garantiza el éxito de nuestros clientes.

Si está listo para desarrollar una estrategia de riesgo más resiliente y proactiva, comience aquí:

Perspectiva práctica 1: Implementar un panel unificado. Centralizar los indicadores de riesgo para que RR. HH., Cumplimiento y Seguridad puedan finalmente colaborar a la perfección.

Perspectiva práctica 2: Céntrese en soluciones sistémicas. Utilice la información basada en IA para identificar y solucionar las causas raíz del riesgo, como la presión poco realista o los canales de comunicación interrumpidos.

Perspectiva práctica 3: Únase a una red de socios. Amplíe sus capacidades y garantice el cumplimiento normativo global uniéndose a nuestra red PartnerLC , diseñada para integradores y asesores como usted.

El futuro es proactivo y ético

El futuro de la gestión de riesgos internos ya está aquí, y se centra en la inteligencia emocional de la inteligencia artificial , no como una herramienta de vigilancia, sino como un sistema para comprender la salud organizacional. Ir más allá del control de daños reactivo significa adoptar un enfoque proactivo y ético que detecte patrones de comportamiento arriesgados mucho antes de que se conviertan en incidentes costosos. Para eso se creó Logical Commander.

Ofrecemos detección en tiempo real y un retorno de la inversión medible, todo ello basado en una política de privacidad prioritaria y en cumplimiento con la EPPA. Nuestra plataforma ayuda a los líderes a fortalecer la integridad y construir una cultura resiliente al abordar problemas sistémicos, en lugar de monitorear a las personas.

¿Está listo para cambiar su estrategia de riesgo de la retrospectiva a la previsión?

Solicite una demostración para ver cómo nuestra plataforma de inteligencia artificial ética transforma la gestión de riesgos internos o únase a nuestra red PartnerLC para llevar estas soluciones innovadoras a sus clientes.

Saber primero. Actuar con rapidez. IA ética para la integridad, el cumplimiento normativo y la dignidad humana.

%20(2)_edited.png)